Pythonでバラバラな画像をいい感じに詰め合わせる

はじめに

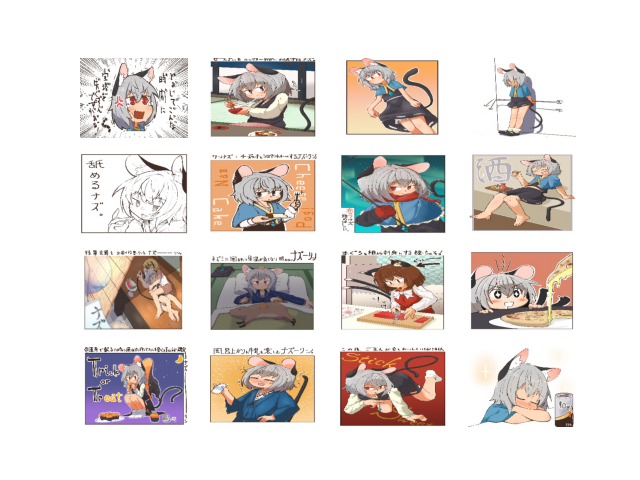

今回は、サイズの異なる複数枚の画像をいい感じに1枚の画像にする方法を考えていきます。

画像サイズが同じであれば簡単に画像を並べる事が出来るのですが、今回はもう少しおしゃれな感じにしたいです。

| こうでなく | こう! |

|---|---|

|

|

右の画像は適当に手で並べ替えただけなのでちょっと不格好ですが、イメージはこんな感じです。

※この素敵なイラストは友人に掲載許可を頂きました[1]

自然言語処理をやってみたい

はじめに

このブログのタイトルにもあるように、平日は企業で研究開発業務に携わっています。

研究を生業にしていく為には、日々投稿される最新の研究論文を常にインプットしていかなくてはならないのですが、研究以外の業務も沢山あるので中々に難しい問題があります。

昨今は「査読付き論文誌や国際会議に投稿する前に、すぐにArxivと呼ばれる論文投稿サイト(査読なし)にペーパーを公開して周りの反応を見る」と言う文化が出来つつ有ります。

これにより良くも悪くも最新研究の投稿速度がますます早くなり、昨今では投稿論文の数が「物理的に人間が読める速度を超えてしまったのではないか?」と言われています。

arXiv.org e-Print archive

かく言う僕も、自分の分野外の研究は、有名な国際会議で投稿された論文(のアブストラクト)を追いかけていくので精一杯です。

このままでは、良質な論文を見逃してしまい、研究者としてのセンスが鈍っていってしまいそうなので、AI/パターン認識の力を借りて論文のインプット量を高めていきたいと思いました。

Python+Pytorchでイラストの生成

はじめに

ブログを執筆したり職場で研究内容を人に伝える際に、積極的にイラストを用いるようにしています。

イラストを用いる事で、言葉で伝えるにはややこしい内容であっても、直感的に理解してもらえる事が多いためです。

しかしながら僕は,単純な図表などはある程度描くことが出来るのですが、複雑なデザインや可愛らしいキャラクターなどは描くことが出来ません。

以下に自分で描いたイラストの一例を示します。

| イラスト例1 | イラスト例2 |

|---|---|

|

|

図表で伝える分にはギリギリ最低限の画力はあると思いますが、まだまだ改善の余地が沢山あると思います。

今回は線画からイラストを生成するAIを構築、学習し、画力の改善を図ってみたいと思います。

作るもの

今回は線画を入力するといい感じに着色してくれるCNNを学習してみたいと思います。

図中の素敵なイラストは、友人のご好意によりお借りしています。[1]

続きを読む逆位相音楽用のイヤフォン作成

はじめに

前回、pythonで逆位相音楽の生成法を紹介しました。

逆位相音楽にすると、以下の様にオリジナルとはまた違ったテイストが出てきます。

| オリジナル | 逆位相音楽 |

|---|---|

この素敵な楽曲は魔王魂様で公開されている「世界が僕らに揺れるまで」です。

非常におおらかなライセンスで素敵な楽曲を公開して頂いている素晴らしいサイトです。

世界が僕達に揺れるまで | 公式歌詞 & 音源無料ダウンロード 魔王魂

逆位相音楽の仕組みやpythonでの生成法は以前の記事を参照してください。

nsr-9.hatenablog.jp

前回の方法は音楽ファイル(mp3, wav)から生成する様なプロセスだったのですが、一回一回変換するのがそこそこ手間のかかる作業でした。

そこで今回は、イヤフォンの半貫状態を再現するコンバーターを作成し、PCから流れてくる音をすべて逆位相変換出来るようにしたいと思います。